서론

안녕하세요! 지난 글에서는 WebRTC의 기본 개념과 연결 구조에 대해 알아보았습니다.

시그널링, SDP, NAT 문제 해결, 그리고 다양한 아키텍처 패턴까지 연결(Connection) 자체를 이해하는 데 집중했는데요.

그렇다면 연결이 된 후, 실제로 주고받는 데이터는 무엇일까요?

바로 미디어 스트림(MediaStream)과 미디어 트랙(MediaStreamTrack)입니다.

처음 WebRTC로 화상 통화를 구현할 때 getUserMedia()를 사용해 카메라를 켜고, 트랙을 다루는 코드를 접해보셨을 겁니다.

하지만 "스트림과 트랙은 무엇이 다를까? 언제 어떤 걸 써야 할까?"라는 의문이 생기기 쉽습니다.

이번 글에서는 MediaStream과 MediaStreamTrack의 개념을 정리하고, 실제로 미디어를 캡처하고 제어하는 방법을 단계별로 살펴보겠습니다.

스트림과 트랙, 뭐가 다를까?

쉽게 생각해보기

MediaStream은 택배 상자라고 생각하면 쉽습니다.

MediaStreamTrack은 상자 안에 담긴 개별 물건입니다.

📦 MediaStream (택배 상자)

├── 🎥 비디오 트랙 (카메라 영상)

└── 🎤 오디오 트랙 (마이크 소리)

하나의 상자(스트림)에 여러 물건(트랙)을 담을 수 있고,

필요하면 물건만 꺼내서 다른 상자에 옮길 수도 있습니다.

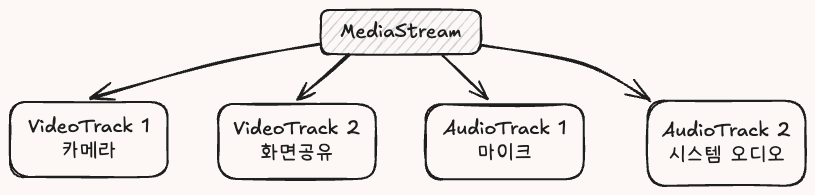

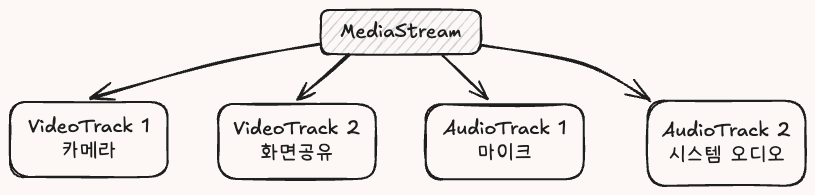

실제로는 어떻게 생겼을까?

MediaStream (컨테이너)

- 여러 트랙을 묶어서 관리

- 고유한 ID로 식별

- 트랙 추가/제거 가능

MediaStreamTrack (실제 데이터)

- 오디오 또는 비디오 중 하나만

- 각자 독립적으로 제어 가능

- 켜기/끄기, 교체, 품질 조절

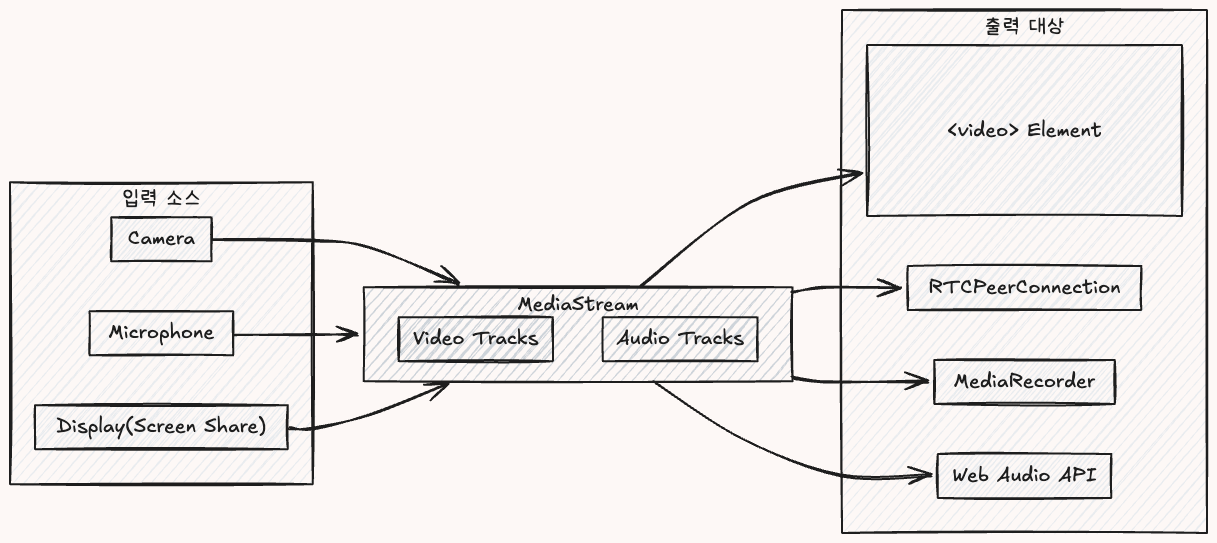

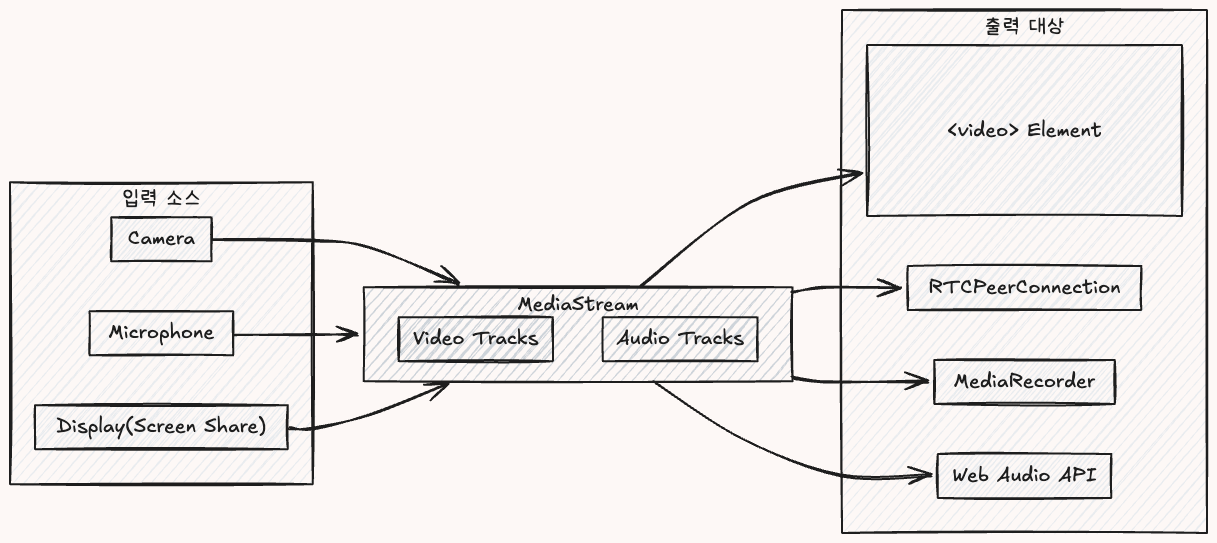

Media Capture and Streams API(줄여서 MediaStream API)는 WebRTC와 함께 사용되는 핵심 API 입니다.

브라우저에서 카메라, 마이크, 화면을 가져오는 기능을 제공합니다.

💡 스트림(Stream)이란?

물이 흐르듯이 데이터가 연속적으로 전달되는 것입니다.

파일을 한 번에 다운로드하는 게 아니라, 조금씩 계속 받아서 재생하는 방식이죠.

무엇을 제공하나요?

1. 미디어 접근

2. 세밀한 제어

- 해상도: 720p? 1080p?

- 프레임률: 30fps? 60fps?

- 에코 제거, 노이즈 제거

3. 안전한 처리

MediaStream은 0개 이상의 트랙을 담는 컨테이너입니다.

무엇을 담을 수 있나요?

가능한 조합들

📦 빈 상자 (트랙 없음)

📦 오디오만

└── 🎤 마이크

📦 비디오만

└── 🎥 카메라

📦 둘 다

├── 🎥 카메라

└── 🎤 마이크

📦 여러 개

├── 🎥 카메라

├── 🖥️ 화면 공유

└── 🎤 마이크

스트림은 어디서 올까?

Local MediaStream (내 장치에서)

Non-local MediaStream (외부에서)

- 네트워크 (상대방이 보낸 영상)

- 비디오 파일 (

<video> 요소)

- Web Audio API (오디오 합성)

스트림은 어디로 갈까?

화면에 보여주기

녹화하기

스트림 다루기

트랙 가져오기

트랙 추가/제거

스트림 복제

상태 변화 감지

트랙이 뭐죠?

실제 미디어 데이터를 담는 개별 단위입니다.

트랙의 생명 주기

live (활성)

📹 카메라 켜짐

⬇

🟢 트랙 생성 (readyState = "live")

⬇

📡 데이터 전송 중

ended (종료)

🛑 트랙 종료 (readyState = "ended")

⬇

📹 카메라 꺼짐

⬇

❌ 다시 켤 수 없음 (새로 만들어야 함)

트랙이 종료되는 경우

- 사용자가 권한 철회

- 장치 연결 해제 (USB 카메라 뽑기)

track.stop() 호출- 브라우저 탭 종료

enabled vs muted

이 둘은 완전히 다릅니다!

enabled (내가 제어)

"이 트랙을 전송할까 말까?"

특징

- ✅ 개발자가 자유롭게 변경 가능

- ⚠️ 카메라 LED는 계속 켜져 있음

- ⚠️ 데이터는 전송되지만 검은 화면/무음

muted (시스템이 결정)

"지금 데이터가 안 나오고 있어요"

muted가 되는 경우

- 장치 연결 문제

- 시스템 권한 변경

- 리소스 부족 (CPU, 메모리)

💡 언제 뭘 쓸까?

- enabled: "화면에서 카메라를 꺼줘!" → UI 버튼으로 제어

- muted: "어? 마이크가 안 되네?" → 사용자에게 알림 표시

트랙 제어하기

트랙 끄기

트랙 복제

미디어 캡처하기

기본 사용법

이렇게 하면

- 브라우저가 권한 요청 팝업 표시

- 사용자가 "허용" 클릭

- 카메라 LED 켜짐

- 스트림 반환

⚠️ 권한이 필요합니다!

사용자가 "차단"을 누르면 에러가 발생합니다.

브라우저 설정에서 직접 권한을 변경해야 합니다.

품질 설정 (Constraints)

해상도 설정

키워드별 동작

| 키워드 | 의미 | 동작 |

|---|

ideal | 이상적인 값 | 최대한 맞추되, 안 되면 비슷한 값 |

exact | 정확히 이 값 | 불가능하면 에러 발생 |

min | 최소값 | 이 값 이상 |

max | 최대값 | 이 값 이하 |

💡 화상 통화 필수 설정

echoCancellation과 noiseSuppression은 반드시 켜세요!

스피커에서 나오는 소리가 다시 마이크로 들어가는 메아리 현상을 막아줍니다.

장치 선택하기

기본 사용법

사용자가 선택할 수 있는 것

⚠️ 시스템 오디오는 제한적

Chrome: Windows/Mac 지원

Firefox: Windows만 지원

Safari: 미지원

화면 공유 종료 감지

실전 활용

여러 소스 결합하기

용도

- 카메라와 화면 공유 동시 전송

- 마이크와 시스템 오디오 믹싱

Canvas로 비디오 합성

여러 비디오를 하나로 합치기 (PIP, 격자 레이아웃 등)

활용 사례

- 화상 회의 격자 레이아웃

- PIP (Picture-in-Picture)

- 워터마크 추가

- 실시간 필터 효과

실전 팁

리소스 정리는 필수!

나쁜 예

좋은 예

권한 에러 처리

HTTPS 필수

getUserMedia()는 보안상의 이유로 HTTPS에서만 작동합니다.

개발 환경

프로덕션

모바일 고려사항

자동재생 제한

화면 잠금 방지

배터리 최적화

마무리

이번 글에서는 WebRTC의 MediaStream과 MediaStreamTrack에 대해 알아보았습니다.

정리

MediaStream (택배 상자)

- 트랙들을 담는 컨테이너

- 고유한

id로 식별

getTracks(), addTrack(), removeTrack() 제공

MediaStreamTrack (개별 물건)

- 실제 미디어 데이터

kind: "audio" 또는 "video"readyState: "live" 또는 "ended"enabled: 출력 제어 (내가 조절)muted: 시스템 상태 (읽기 전용)

미디어 캡처

getUserMedia(): 카메라/마이크getDisplayMedia(): 화면 공유- Constraints로 품질 설정

필수 주의사항

- 리소스 정리 (

track.stop())

- 권한 에러 처리

- HTTPS 필수

- 모바일 최적화

다음 글에서는 RTCPeerConnection의 이벤트 흐름을 다루겠습니다.

- PeerConnection 생성과 설정

- 미디어 트랙 추가하기 (

addTrack)

- 트랙 동적 제어 (

replaceTrack, removeTrack)

- 연결 상태 변화 감지

- 협상 과정 이해

- 에러 처리와 재연결

끝까지 읽어주셔서 감사합니다!

![[WebRTC 박살내기 #2] 미디어 스트림과 트랙 완벽 이해](/_next/image?url=%2Fposts%2Fwebrtc-deepdive-02%2Fimages%2Fthumbnail.png&w=3840&q=75)

![[WebRTC 박살내기 #1] WebRTC 개념과 연결 구조 완전 정리](/_next/image?url=%2Fposts%2Fwebrtc-deepdive-01%2Fimages%2Fthumbnail.png&w=3840&q=75)

![[WebRTC 박살내기 #3] PeerConnection API와 이벤트 흐름](/_next/image?url=%2Fposts%2Fwebrtc-deepdive-03%2Fimages%2Fthumbnail.png&w=3840&q=75)

![[WebRTC 박살내기 #4] 데이터 채널 구조와 활용법](/_next/image?url=%2Fposts%2Fwebrtc-deepdive-04%2Fimages%2Fthumbnail.png&w=3840&q=75)